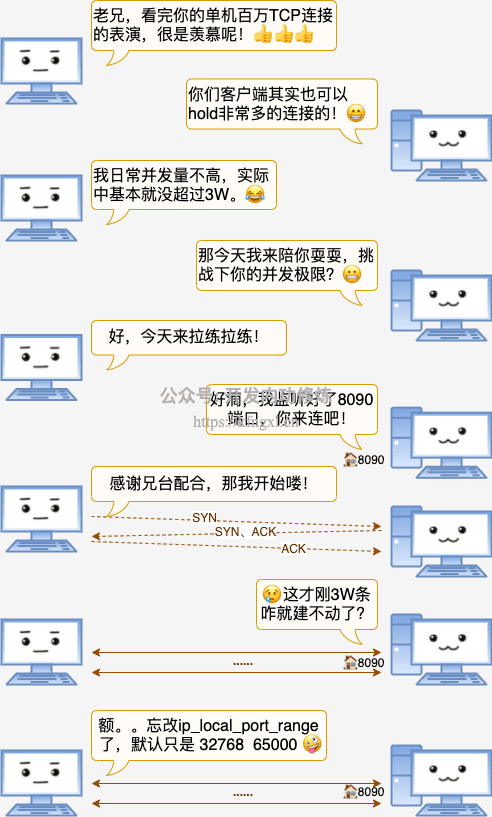

echo "5000 65000" > /proc/sys/net/ipv4/ip_local_port_range

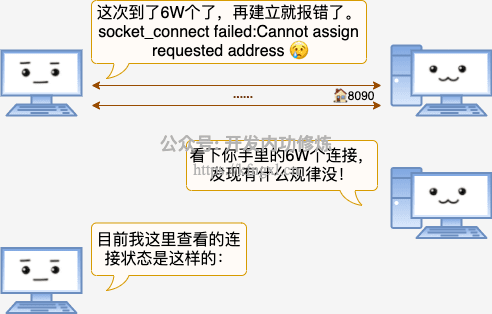

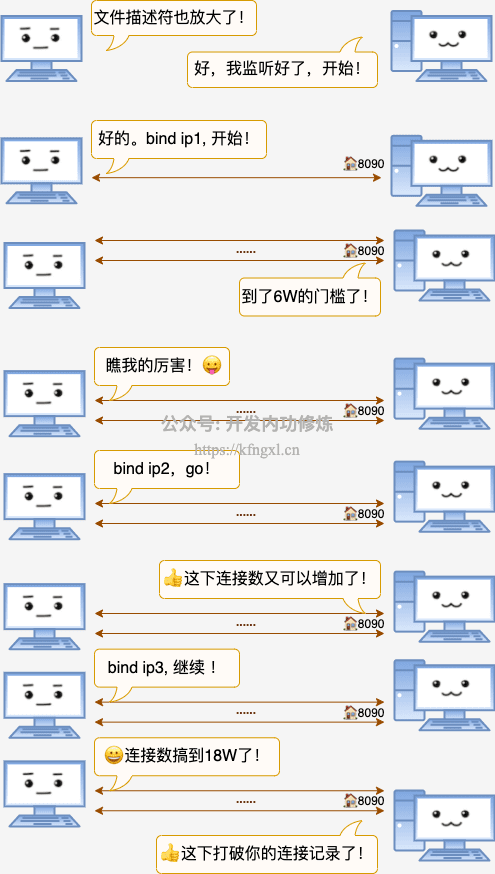

- 连接1: 192.168.1.101 5000 192.168.1.100 8090

- 连接2: 192.168.1.101 5001 192.168.1.100 8090

- 连接N: 192.168.1.101 ... 192.168.1.100 8090

- 连接6W: 192.168.1.101 65000 192.168.1.100 8090

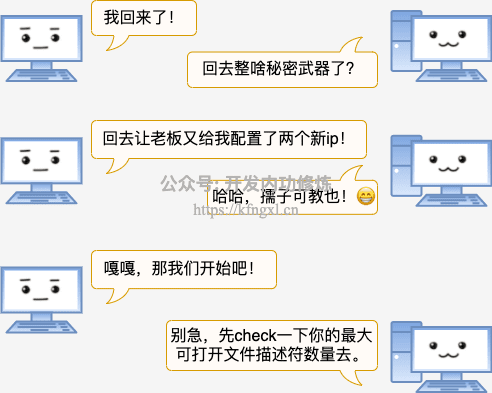

//修改整个系统能打开的文件描述符为20W

echo 200000 > /proc/sys/fs/file-max

//修改所有用户每个进程可打开文件描述符为20W

#vi /etc/sysctl.conf

fs.nr_open=210000

#sysctl -p

#vi /etc/security/limits.conf

* soft nofile 200000

* hard nofile 200000注意: limits中的hard limit不能超过nr_open, 所以要先改nr_open。而且最好是在sysctl.conf中改。避免重启的时候 hard limit生效了,nr_open不生效导致启动问题。

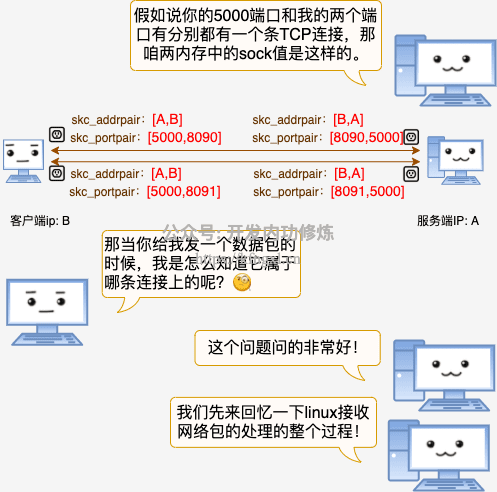

“socket中有一个主要的数据结构sock_common,在它里面有两个联合体。”

// file: include/net/sock.h

struct sock_common {

union {

__addrpair skc_addrpair; //TCP连接IP对儿

struct {

__be32 skc_daddr;

__be32 skc_rcv_saddr;

};

};

union {

__portpair skc_portpair; //TCP连接端口对儿

struct {

__be16 skc_dport;

__u16 skc_num;

};

};

......

}“其中skc_addrpair记录的是TCP连接里的IP对儿,skc_portpair记录的是端口对儿。”

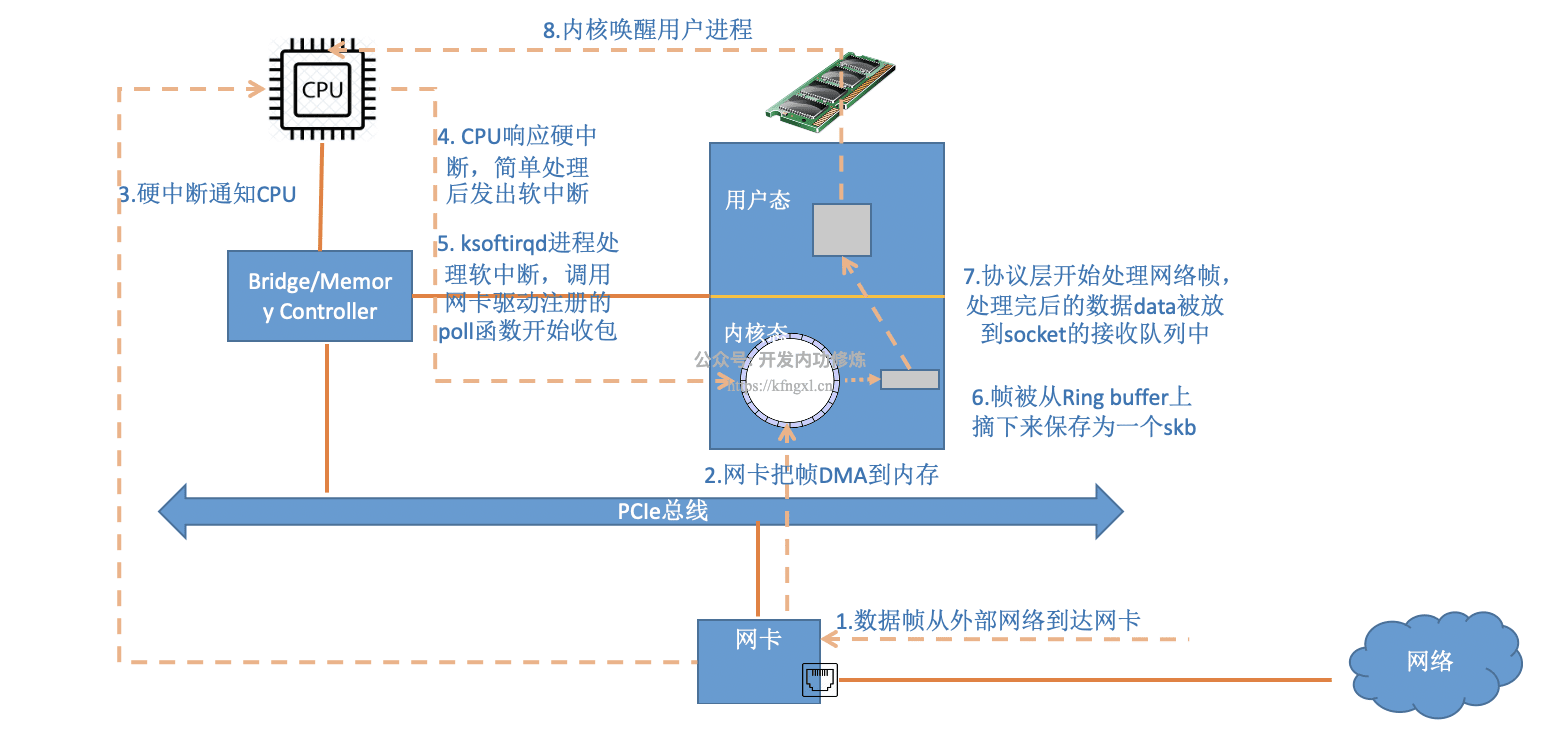

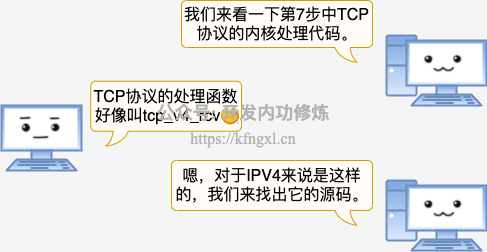

“在网络包到达网卡之后,依次经历DMA、硬中断、软中断等处理,最后被送到socket的接收队列中了。”

“对于TCP协议来说,协议处理的入口函数是 tcp_v4_rcv。我们看一下它的代码”

// file: net/ipv4/tcp_ipv4.c

int tcp_v4_rcv(struct sk_buff *skb)

{

......

th = tcp_hdr(skb); //获取tcp header

iph = ip_hdr(skb); //获取ip header

sk = __inet_lookup_skb(&tcp_hashinfo, skb, th->source, th->dest);

......

}

// file: include/net/inet_hashtables.h

static inline struct sock *__inet_lookup(struct net *net,

struct inet_hashinfo *hashinfo,

const __be32 saddr, const __be16 sport,

const __be32 daddr, const __be16 dport,

const int dif)

{

u16 hnum = ntohs(dport);

struct sock *sk = __inet_lookup_established(net, hashinfo,

saddr, sport, daddr, hnum, dif);

return sk ? : __inet_lookup_listener(net, hashinfo, saddr, sport,

daddr, hnum, dif);

}“先判断有没有连接状态的socket,这会走到\_\_inet_lookup_established函数中”

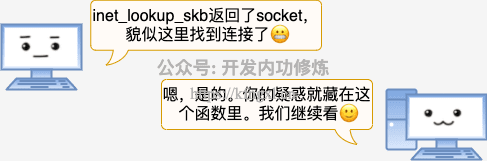

//file: net/ipv4/inet_hashtables.c

struct sock *__inet_lookup_established(struct net *net,

struct inet_hashinfo *hashinfo,

const __be32 saddr, const __be16 sport,

const __be32 daddr, const u16 hnum,

const int dif)

{

//将源端口、目的端口拼成一个32位int整数

const __portpair ports = INET_COMBINED_PORTS(sport, hnum);

......

//内核用hash的方法加速socket的查找

unsigned int hash = inet_ehashfn(net, daddr, hnum, saddr, sport);

unsigned int slot = hash & hashinfo->ehash_mask;

struct inet_ehash_bucket *head = &hashinfo->ehash[slot];

begin:

//遍历链表,逐个对比直到找到

sk_nulls_for_each_rcu(sk, node, &head->chain) {

if (sk->sk_hash != hash)

continue;

if (likely(INET_MATCH(sk, net, acookie,

saddr, daddr, ports, dif))) {

if (unlikely(!atomic_inc_not_zero(&sk->sk_refcnt)))

goto begintw;

if (unlikely(!INET_MATCH(sk, net, acookie,

saddr, daddr, ports, dif))) {

sock_put(sk);

goto begin;

}

goto out;

}

}

}

// include/net/inet_hashtables.h

#define INET_MATCH(__sk, __net, __cookie, __saddr, __daddr, __ports, __dif) \

((inet_sk(__sk)->inet_portpair == (__ports)) && \

(inet_sk(__sk)->inet_daddr == (__saddr)) && \

(inet_sk(__sk)->inet_rcv_saddr == (__daddr)) && \

(!(__sk)->sk_bound_dev_if || \

((__sk)->sk_bound_dev_if == (__dif))) && \

net_eq(sock_net(__sk), (__net)))“在INET_MATCH中将网络包tcp header中的__saddr、\_\_daddr、\_\_ports和Linux中的socket中inet_portpair、inet_daddr、inet_rcv_saddr进行对比。如果匹配socket就找到了。当然除了ip和端口,INET_MATCH还比较了其它一些东东,所以TCP还有五元组、七元组之类的说法。”

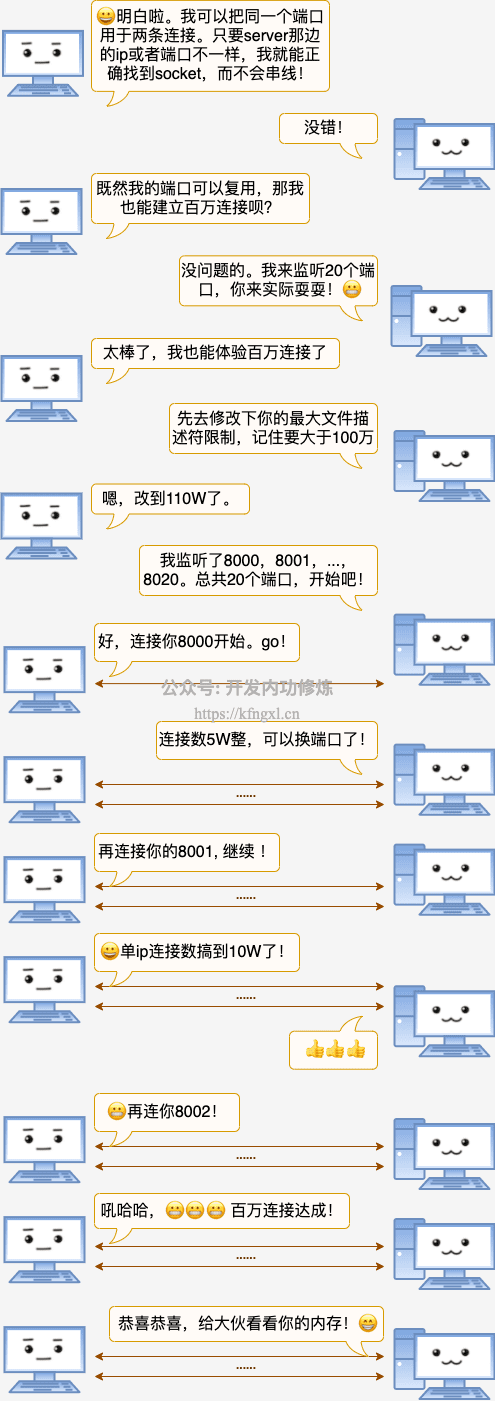

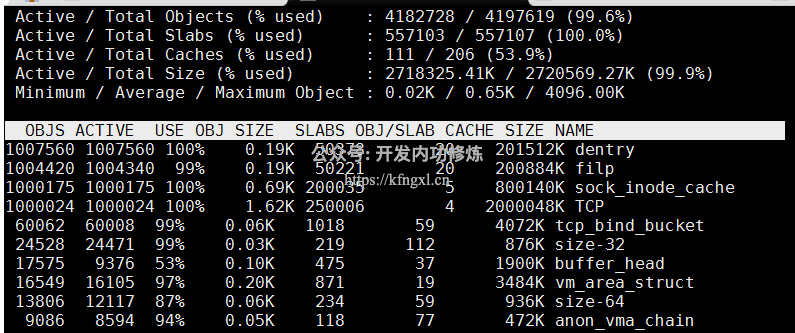

# cat /etc/redhat-release

Red Hat Enterprise Linux Server release 6.2 (Santiago)

# ss -ant | grep ESTAB |wc -l

1000013

# cat /proc/meminfo

MemTotal: 3925408 kB

MemFree: 97748 kB

Buffers: 35412 kB

Cached: 119600 kB

......

Slab: 3241528 kB

总结

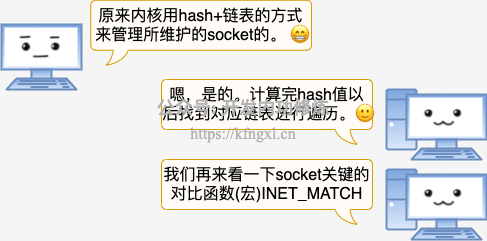

客户端每建立一个连接就要消耗一个端口,所以很多同学当看到客户端机器上连接数一旦超过3W、5W就紧张的不行,总觉得机器要出问题了。

这篇文章第一版很早就写出来了,不过飞哥又打磨了有一周之多。在文中我们展示了一下 TCP socket的少量内核代码。通过源码来看:

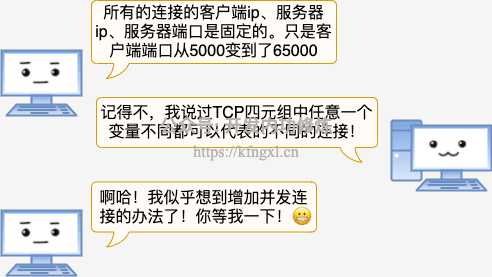

TCP连接就是在客户机、服务器上的一对儿的socket。它们都在各自内核对象上记录了双方的ip对儿、端口对儿(也就是我们常说的四元组),通过这个在通信时找到对方。

TCP连接发送方在发送网络包的时候,会把这份信息复制到IP Header上。网络包带着这份信物穿过互联网,到达目的服务器。目的服务器内核会按照 IP 包 header 中携带的信物(四元组)去匹配找到正确的socket(连接)。

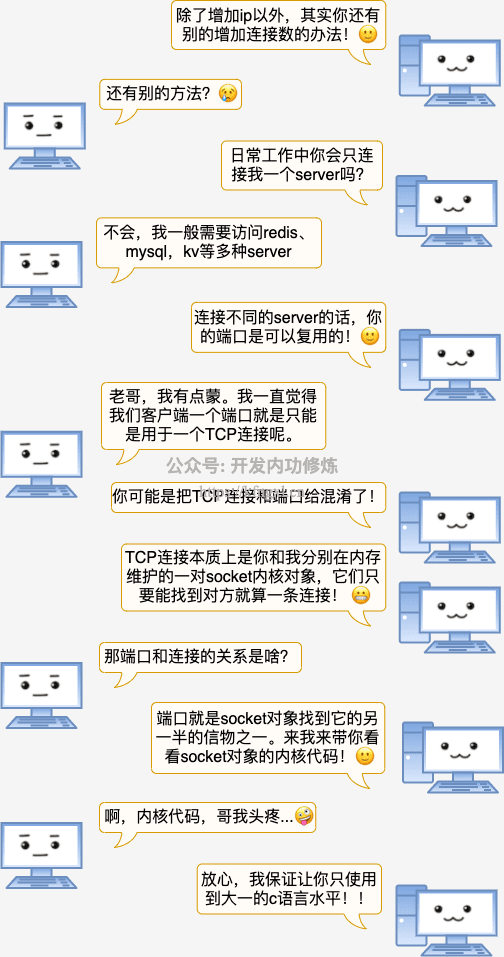

在这个过程里我们可以看到,客户端的端口只是这个四元组里的一元而已。哪怕两条连接用的是同一个端口号,只要客户端ip不一样,或者是服务器不一样都不影响内核正确寻找到对应的连接,而不会串线!

所以在客户端增加TCP最大并发能力有两个方法。第一个办法,为客户端配置多个ip。第二个办法,连接多个不同的server。

不过这两个办法最好不要混用。因为使用多 IP 时,客户端需要bind。一旦bind之后,内核建立连接的时候就不会选择用过的端口了。bind函数会改变内核选择端口的策略~~

最后我们亲手实验证明了客户端也可以突破百万的并发量级。相信读过此文的你,以后再也不用再惧怕65535这个数字了。

写在最后,由于我的这些知识在公众号里文章比较分散,很多人似乎没有理解到我对知识组织的体系结构。而且图文也不像视频那样理解起来更直接。所以我在知识星球上规划了视频系列课程,包括硬件原理、内存管理、进程管理、文件系统、网络管理、Golang语言、容器原理、性能观测、性能优化九大部分大约 120 节内容,每周更新。加入方式参见我要开始搞知识星球啦、如何才能高效地学习技术,我投“融汇贯通”一票

Github:https://github.com/yanfeizhang/coder-kung-fu

关注公众号:微信扫描下方二维码

开发内功修炼@张彦飞

开发内功修炼@张彦飞